La realidad y la ficción están a punto de volverse indistinguibles. El lanzamiento de Sora, la nueva tecnología de OpenAI sorprendió al mundo y alarmó a cualquiera prestando atención ala rápida evolución de estas herramientas que hace pocos años se volvieron de acceso abierto. Esta vez el nuevo modelo de inteligencia artificial de OpenAI tiene la capacidad de convertir contenido de texto a video. Con un prompt de tan sólo un párrafo Sora es capaz de lanzarte un video de medio minuto hyper-realista, con personajes humanos, paisajes detallados, cortes y cambios de plano incluidos. Y no sólo crea videos elaborados basados en un par de oraciones descriptivas, sino que lo hace con una nitidez sin precedentes en cuestión de segundos.

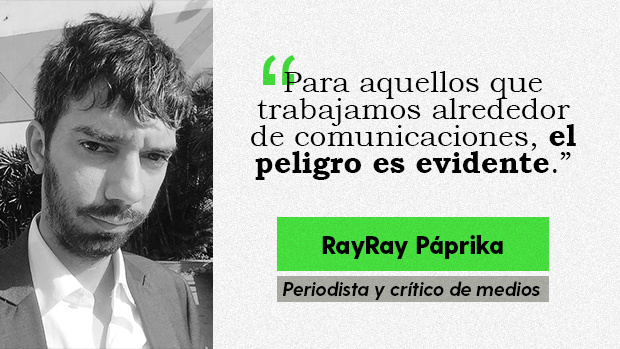

Aunque todos ya hayamos tenido la oportunidad de experimentar con las limitaciones del software de inteligencia artificial (intenta tener una conversación filosófica con ChatGPT y luego intenta convencerle de que te ha vuelto ateo, es gracioso), los paradigmas quizá estén cambiando más rápido de lo que podamos adaptarnos. No sólo las imágenes creadas artificialmente nos están engañando cada vez más fácilmente, sino también el texto. En un estudio realizado en Junio del 2023 en el que participaron 1.5 millones de personas, se halló que al menos el 32% no podían distinguir si estaban chateando con un bot o una persona real.

Y si muchos caemos ante estafas así de simples, imagínate cuando venga con video y audio haciéndose pasar por un familiar

Para aquellos que trabajamos alrededor de comunicaciones (o tenemos familiares a los que quisiéramos quitarles el acceso a Whatsapp) el peligro es evidente. El hecho de que cualquier persona tenga la habilidad de crear videos hyper-realistas en cuestión de segundos se presta para la llegada de una nueva era de fake news. Ejemplos de esto ya han ido surgiendo a través de los años, como por ejemplo un famoso deepfake de Barack Obama publicado por Buzzfeed allá en el 2018 en el que ya advertían sobre los peligros del uso de esta tecnología para crear falsa información. La diferencia es que en el 2018 necesitabas todo un equipo de tecnología y profesionales detrás para crear un video así; dentro de poco cualquier adolescente podrá hacerlo desde su celular.

Y en el mejor de los casos lo usarán para hacer cosas como esta

Esta tecnología siendo usada para generar contenido ya ha traído problemas en el mundo real. Si recordamos hace unos meses la aparición de una canción ‘Nostalgia’ de Bad Bunny tomó por sorpresa al mundo cuando nos dimos cuenta que en la participación del cantante portoriquense en realidad había sido generada a través de inteligencia artificial. El éxito de esta canción fanmade superó en vistas de Youtube a varias otras canciones originales de Bad Bunny (a pesar que se paran bajando los videos por temas de copyright), lo que ocasionó un berrinche por parte del artista, demandas, y eventualmente terminó opacando el lanzamiento de su nuevo álbum irónicamente titulado ‘Nadie sabe lo que va a pasar mañana’.

En temas más seriamente criminales, Taylor Swift también fue víctima del mal uso de tecnología cuando a inicios de este año se propagaron por Internet imágenes pornográficas de ella generadas a través de inteligencia artificial. Esta combinación de deepfakes con revenge porn ha existido desde la aparición de Photoshop, pero dada la alta visibilidad del caso, acciones veloces han sido tomadas: el creador de las imágenes fue arrestado y a fines de Enero el Congreso norteamericano empezó a discutir legislación pertinente a la generación y distribución de pornografía generada por inteligencia artificial.

La tecnología también fue usada para crear imágenes falsas de un evento real: el arresto de Trump

La invención de mentiras no es novedad, pero la rápida aceleración de la tecnología y su accesibilidad que permite crear mentiras bastante creíbles va a ser un nuevo problema al cual enfrentarnos. A pesar que son temas que necesitan legislarse urgentemente, muy probablemente las leyes no sean capaces de defendernos del panorama post-apocalíptico en el que ya no sólo tenemos a personas generando contenido para engañarnos, sino que tengamos una Internet plagada de inteligencias artificiales generando contenido con algún fin ulterior con el que hayan sido programados.

Durante el Super Bowl, se sospecha que por momentos hasta el 75% del tráfico de cuentas de Twitter con las marcas publicitadas fue generado por bots. En otra ocasión, durante el primer debate de las elecciones primarias republicanas, también se halló que había una gran cantidad de desinformación siendo propagada paralelamente por cuentas falsas y bots. Es decir, con la inteligencia artificial hasta los trolls se van a quedar sin trabajo.

El aluvión de contenido generado por inteligencia artificial es inevitable. Quizá podamos hacer algunas leyes para prevenir que empresas se aprovechen de ella de maneras comprobablemente nefastas. Quizá podamos penalizar la creación de contenido que atente contra los derechos de otros (aunque, ¿sería atentar contra la libertad de expresión?). Quizá incluso alguien invente algún tipo de marca de agua para poder verificar que un video es real, pero la verdad que mientras tanto sólo nos queda dudar de todo. Las señales que antes delataban a un video de inteligencia artificial (como malos ángulos o manos con demasiados dedos) ya están empezando a desaparecer así que de aquí en adelante nos esperan constantes y urgentes métodos de adaptación para no volvernos peligrosamente crédulos.

Ray Ray Paprika (a) «Rafael Gutiérrez» es periodista y crítico de medios.